Se caracterizan por conectar y realizar funciones principalmente de mando con un coste energético relativamente bajo, siendo utilizados principalmente para el procesamiento de señales. Aunque existen numerosos tipos y diferentes construcciones, el principio de funcionamiento para todos ellos es similar

Un relé está formado por una bobina con un núcleo de hierro y uno o más contactos, los cuales conmutarán su posición ante la aparición de un campo magnético creado por la propia bobina.

En posición de reposo (sin alimentación eléctrica a la bobina), un resorte empuja una lámina de material conductor basculante, la cual se encuentra separada del núcleo. En estos momentos existe una conexión entre las bornas “común” y “NC” (normalmente cerrado).

Cuando se active el pulsador, el circuito quedará cerrado, existiendo una alimentación eléctrica a la bobina, la cual crea un campo magnético capaz de atraer a la lámina basculante venciendo la fuerza realizada por el resorte en oposición

Es entonces cuando se produce la conmutación de los contactos, existiendo comunicación entre las bornas “común” y “NA” (normalmente abierto). Si en un determinado momento se produce el corte de alimentación a la bobina, esta dejará de producir flujo electromagnético y el relé retornará a su posición inicial, debido a la fuerza de recuperación que realizará el resorte. Es precisamente por este efecto por el que los relés de este tipo son considerados monoestables (solo tienen una posición estable), debiéndose tener este aspecto en cuenta para la realización de los circuitos.

Es entonces cuando se produce la conmutación de los contactos, existiendo comunicación entre las bornas “común” y “NA” (normalmente abierto). Si en un determinado momento se produce el corte de alimentación a la bobina, esta dejará de producir flujo electromagnético y el relé retornará a su posición inicial, debido a la fuerza de recuperación que realizará el resorte. Es precisamente por este efecto por el que los relés de este tipo son considerados monoestables (solo tienen una posición estable), debiéndose tener este aspecto en cuenta para la realización de los circuitos.APLICACIONES DE UN RELÉ

Inversión de contactos: de esta manera eliminamos una limitación muy frecuente de algunos sensores que se utilizan como dispositivo de entrada, ya que con la utilización del relé no importa si el contacto del sensor es abierto o cerrado, pues lo transformamos en el que más nos interese.

Multiplicación de contactos: el relé permite multiplicar los contactos de salida de un sensor con la simple conexión de este a una bobina de un relé, en el cual tendremos varios de estos contactos. Al activar el sensor, excita la bobina y mueve los contactos, que utilizaremos a nuestro antojo.

Amplificación de potencia: en determinadas ocasiones, es posible que los sensores colocados en la instalación no permitan el paso de la intensidad deseada. Una rápida solución la encontramos en la utilización de relés, en lo que podría denominarse un mando indirecto.

Cambio de tensión: los relés permiten que la tensión de entrada a la bobina, por ejemplo, sea en continua, y la aplicada en los contactos en alterna y viceversa. De esta manera podemos utilizar señales en continua para mover aparatos en alterna y viceversa.

memoria: en los circuitos automáticos, todas las discriminaciones (acciones desarrolladas para eliminar la doble señal eléctrica) se realizan por medio de relés, denominados memorias. Esta aplicación se llama realimentación.

* TIPOS DE RELÉS

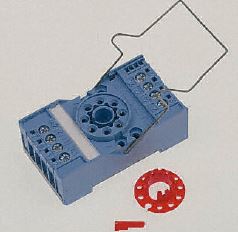

RELÉS ENCHUFABLES

constan de dos partes:

constan de dos partes: Cabeza del relé: es el elemento que contiene todos los mecanismos (contactos, bobina...).

Zócalo o base enchufable: contiene una serie de clavijas en donde encajan las propias de la cabeza; estas clavijas están conectadas a unos bornes para facilitar la conexión a los conductores. Si por cualquier motivo se deteriora el mecanismo, se puede sustituir, puesto que encajaría perfectamente en esta base.

- PARA CIRCUITO IMPRESO

Estos elementos se usan en electrónica y a diferencia de los anteriores, carecen

de base, de modo que únicamente llevan unas patillas que se sueldan al circuito.

- DE ENCLAVAMIENTO se caracteriza por no ser monoestable ya que es biestable— y por actuar por impulso eléctrico es decir, pulsas el pulsador y se conecta, lo vuelves a pulsar y se desconecta

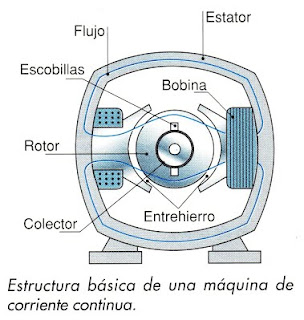

- DE CONTINUA: pensados para corrientes continuas, por lo que la bobina está pensada para las características de este tipo de corriente